Introduction : Le Paradigme du “No Data Left Behind”

Après avoir exploré la cryptographie homomorphe et l’IA confidentielle, nous abordons maintenant le Federated Learning.

Pendant des décennies, le Machine Learning a suivi un principe simple : pour que l’IA apprenne, il faut que les données aillent au modèle. Cette centralisation est la source de l’efficacité du Cloud, mais aussi la source de tous les risques majeurs en matière de confidentialité.

Le stockage centralisé crée un point unique de défaillance, rendant les entreprises vulnérables à la conformité (RGPD, HIPAA) et aux fuites massives.

Le Federated Learning (FL), ou Apprentissage Fédéré, inverse radicalement ce paradigme.

Vulgarisation pour les non initiés

Imaginez que votre smartphone “apprenne” à vous connaître sans jamais envoyer vos messages ou vos photos dans le cloud. C’est exactement ce que fait le Federated Learning.

Dans une architecture FL, le principe devient : le modèle va aux données.

Le FL est un type d’apprentissage automatique distribué où le modèle d’IA est entraîné localement sur des millions d’appareils de périphérie (Edge devices) – téléphones, capteurs IoT industriels, ou serveurs d’hôpitaux – sans que les données brutes ne quittent jamais leur source.

Seules les mises à jour des modèles (les gradients) sont envoyées vers un serveur central pour être agrégées.

Ce n’est pas seulement une répartition de charge classique ; ici, la priorité est la confidentialité.

Le FL est l’une des pierres angulaires de la stratégie Edge Computing pour l’IA, car il permet d’exploiter des données riches et hétérogènes (et donc très utiles) qui seraient autrement trop sensibles pour être centralisées.

L’Architecture Fédérée : Le Protocole en Cinq Étapes

L’entraînement fédéré suit un protocole de communication strict entre le serveur central (qui maintient le modèle global) et les clients (les appareils périphériques). Ce protocole est un cycle continu de communication et de calcul qui définit l’architecture du FL :

Sélection Stochastique des Clients (Sampling)

À chaque cycle d’entraînement (ou round), le serveur sélectionne aléatoirement un petit sous-ensemble d’appareils actifs (clients) pour participer. Cette sélection est souvent basée sur des critères de disponibilité (appareil connecté au Wi-Fi, niveau de batterie suffisant).

“Broadcast” du Modèle Global

Le serveur envoie une copie de l’état actuel du modèle global (Wt) à tous les clients sélectionnés. Le modèle est léger car il s’agit uniquement des poids et des biais.

Entraînement Local et Descente de Gradient

Chaque client entraîne le modèle global sur son propre jeu de données local (Dk). Il effectue une descente de gradient, apprenant des caractéristiques spécifiques à ses données.

Le client génère ainsi une mise à jour locale (ΔWk). C’est l’étape de calcul qui protège la donnée brute.

Envoi des Mises à Jour (Gradients)

Les clients renvoient leurs mises à jour (ΔWk) – et non les données brutes – au serveur central. Ces mises à jour sont généralement chiffrées ou obscurcies pour ne pas divulguer d’information sensible par inversion de gradient.

Agrégation Sécurisée (Federated Averaging – FedAvg)

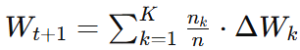

Le serveur agrège toutes les mises à jour locales reçues. L’algorithme Federated Averaging (FedAvg) est la méthode la plus courante : il calcule une moyenne pondérée des mises à jour pour créer la nouvelle version du modèle global (Wt+1).

Le poids de chaque mise à jour est souvent proportionnel à la quantité de données d’entraînement utilisées par le client.

où nk est la taille du jeu de données du client k,

n la taille totale,

ΔWk la mise à jour locale.

Le modèle global mis à jour est prêt pour le cycle suivant.

L’Enfer de l’Hétérogénéité (Défis d’Ingénierie)

Si le protocole FL est élégant en théorie, sa mise en œuvre dans le monde réel est confrontée à une réalité chaotique : le réseau est instable et les données ne sont pas uniformes. Ce sont ces défis qui exigent une expertise d’ingénierie avancée.

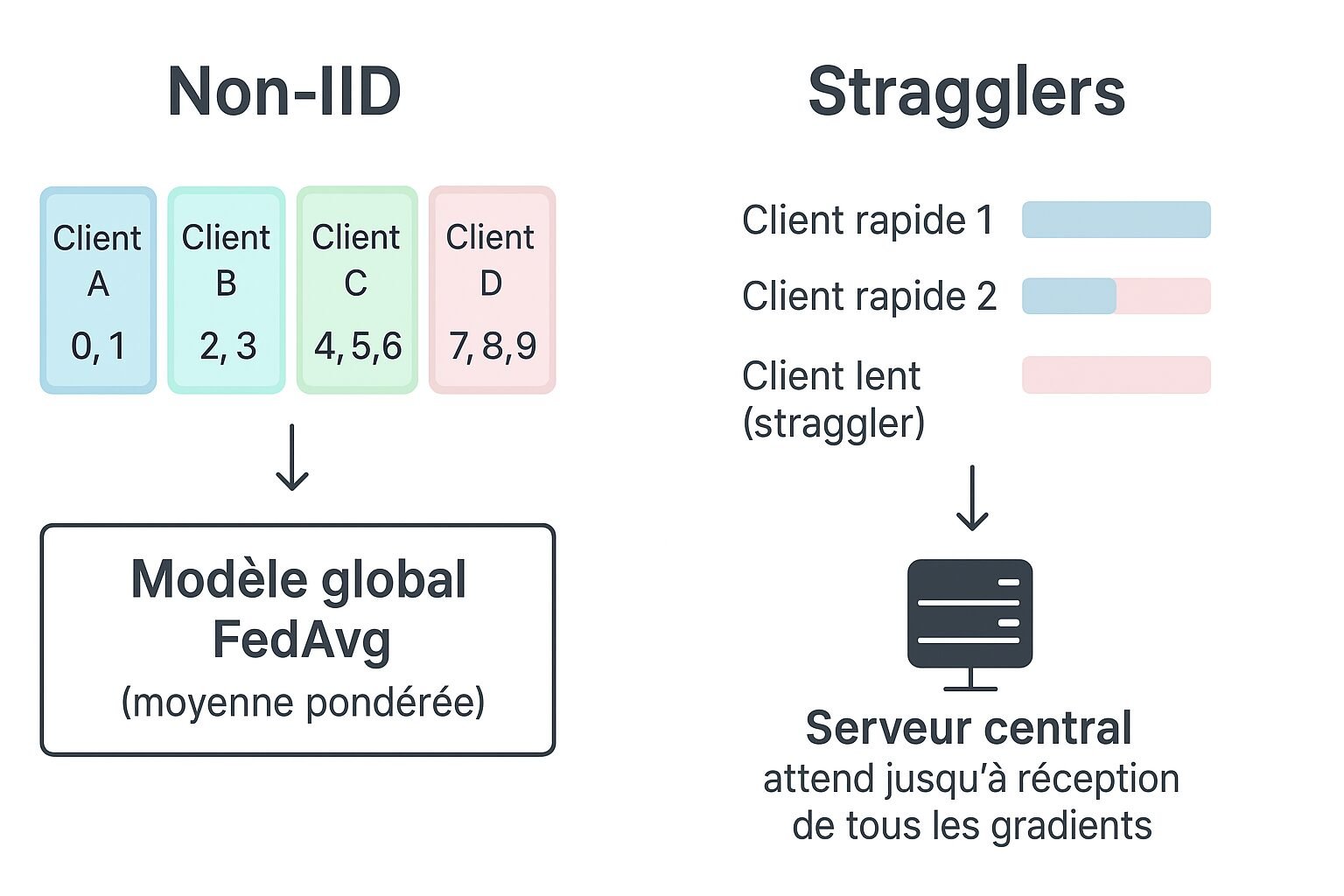

Le Problème du Non-IID (Non-Identically and Independently Distributed)

C’est le cauchemar du Federated Learning. En ML centralisé, on suppose que les données sont distribuées de manière identique et indépendante (IID). Dans le FL, cette hypothèse s’effondre :

Non-Identiquement Distribué

Chaque client (par exemple, le téléphone d’un utilisateur) possède des données qui reflètent uniquement ses habitudes. Un modèle de clavier prédictif entraîné sur le téléphone d’un médecin verra beaucoup plus de jargon médical que celui d’un développeur.

Si le serveur agrège ces modèles trop rapidement, le modèle global risque d’être fortement biaisé vers les habitudes des clients majoritaires.

Conséquence

Le modèle global peine à converger, car chaque mise à jour locale (ΔWk) tire le modèle dans une direction différente. La performance finale est souvent inférieure à celle d’un modèle entraîné de manière centralisée.

La Gestion des Défaillances et des Stragglers

Les clients dans un environnement Edge sont par nature non fiables : leur connexion est intermittente, leur batterie se vide, ou ils sont mis hors ligne par l’utilisateur.

Le Défi des Stragglers

Ce sont les appareils qui sont sélectionnés pour un cycle d’entraînement, mais qui mettent un temps déraisonnable à envoyer leur mise à jour. Dans un système synchrone, le serveur doit attendre le plus lent, ce qui ralentit considérablement l’ensemble du processus.

Solutions architecturales

Les stratégies asynchrones ou semi-synchrones (où l’on fixe un délai maximal et l’on ignore les retards) sont utilisées pour contourner ce problème, mais elles introduisent de la complexité dans le calcul de la moyenne FedAvg.

Le Coût de la Communication

Bien que le FL n’envoie que les mises à jour de modèles (gradients) et non les données brutes, le coût de la communication reste le principal goulot d’étranglement par rapport au temps de calcul :

Les modèles d’IA, même sans les données, peuvent contenir des millions de paramètres. L’envoi répété de ces tensors sur des réseaux mobiles ou Wi-Fi instables est coûteux en bande passante.

Optimisations d’Ingénierie

Pour réduire ce coût, les développeurs emploient la compression des modèles (quantification des poids en entiers 8 bits) ou le sélectionnisme des mises à jour (n’envoyer que les gradients qui ont dépassé un certain seuil de changement).

En pratique

Exemple pratique : Imaginez une application de santé sur smartphone. Chaque téléphone calcule localement comment ajuster le modèle de prédiction de risque de diabète. Seuls les résultats chiffrés sont envoyés au serveur central, qui met à jour le modèle global sans jamais voir vos données personnelles.

Implémentation Pratique et Frameworks (PoC)

Le succès du FL dépend de la capacité des plateformes à gérer la complexité architecturale pour l’ingénieur.

Frameworks Majeurs

| Framework | Langage(s) | Focus Principal | Scénarios PoC Recommandés |

| TensorFlow Federated (TFF) | Python | Architecture de Protocole : Gère les étapes 1 à 5, l’orchestration client-serveur et l’optimisation des communications. | Idéal pour les ingénieurs qui veulent se concentrer sur l’architecture FL pure (non-IID, FedAvg). |

| PySyft (OpenMined) | Python | Sécurité et Cryptographie : Construit pour intégrer nativement DP, FHE (via TenSEAL), et Secure Multi-Party Computation. | Recommandé pour tester les systèmes hybrides (FL + FHE) et les garanties de confidentialité. |

A noter que FLower est une alternative moderne à TFF et PySyft.

Guide d’Expérimentation (PoC Rapide)

Pour nous, chez Techmastermind, une première PoC doit se concentrer sur l’architecture et le défi du Non-IID :

- Plateforme : Utiliser TensorFlow Federated (TFF) en mode simulateur (le serveur central et les clients sont simulés sur une seule machine).

- Dataset : Utiliser le dataset MNIST, mais le partitionner de manière Non-IID. Par exemple, le client A ne reçoit que des images de “0” et “1”, le client B que des “2” et “3”, etc.

Remarque importante : MNIST Non-IID est un exemple pédagogique. Pour des données réelles il faudra gérer encore plus d’hétérogénéité et de stragglers. - Benchmark : Mesurer la vitesse de convergence du modèle global FedAvg. Le modèle prendra beaucoup plus de temps à atteindre une bonne précision que le modèle centralisé (cela prouvera le défi du Non-IID).

- Tuning : Expérimenter en ajustant le nombre de clients sélectionnés à chaque cycle (étape 1) pour voir l’impact sur la vitesse et la précision du modèle global.

Sécurité et Confidentialité – Le Complément FHE

Bien que le FL soit conçu pour la confidentialité, il n’est pas infaillible. Le fait de ne pas envoyer la donnée brute est une énorme avancée, mais cela ne protège pas contre l’extraction d’informations sensibles à partir des mises à jour du modèle (les gradients) envoyées au serveur.

Le développeur doit donc mettre en place des défenses cryptographiques et statistiques supplémentaires.

L’Attaque par Inversion de Gradient

Le maillon faible du FL réside dans l’étape 4, lorsque les clients envoient leurs mises à jour (ΔWk). Les recherches ont montré qu’un attaquant interne (un administrateur du serveur central) peut utiliser ces gradients pour reconstruire ou inférer des informations sur les données d’entraînement originales du client. C’est l’Attaque par Inversion de Gradient.

C’est pourquoi le FL, seul, n’est pas suffisant pour une confidentialité absolue.

La Protection Statistique : La Confidentialité Différentielle (Differential Privacy – DP)

Pour contrer l’inversion de gradient, la solution la plus courante est la Confidentialité Différentielle (DP).

Le DP fonctionne en ajoutant une quantité contrôlée de bruit aléatoire aux mises à jour du modèle avant qu’elles ne soient renvoyées au serveur central.

Effet

L’ajout de bruit masque les contributions exactes d’une seule donnée utilisateur. Si l’on ajoute ou retire un utilisateur de l’ensemble de données, le changement dans le gradient est statistiquement négligeable. Cela garantit qu’aucune donnée d’un client spécifique ne peut être déduite.

Compromis

Le DP garantit la confidentialité, mais la quantité de bruit ajoutée a un coût sur la précision finale du modèle. L’ingénieur doit trouver le bon équilibre entre la garantie de confidentialité (le paramètre ϵ) et la performance du modèle.

Le Complément Cryptographique : FHE et PQC pour l’Agrégation

Comme détaillé dans notre article précédent sur le FHE, ce chiffrement permet d’agréger des données chiffrées sans jamais révéler leur contenu. Ici, il s’applique directement aux gradients envoyés par les clients.

La dernière faille se situe à l’étape 5, l’Agrégation Moyenne (FedAvg). Que se passe-t-il si le serveur central est compromis et qu’il reçoit des gradients (même bruités par DP) de tous les clients ?

Le FHE intervient ici comme un complément parfait :

Rôle du FHE

Au lieu d’envoyer les gradients en clair, les clients utilisent le FHE pour chiffrer leurs mises à jour avant l’envoi. Le serveur central peut effectuer l’opération de moyenne directement sur les gradients chiffrés, éliminant le risque d’attaque interne lors de l’agrégation.

Garantie PQC

Enfin, pour une sécurité pérenne, il est essentiel que les mécanismes de chiffrement utilisés par le FL et le FHE soient basés sur des schémas Post-Quantiques (comme le RLWE mentionné dans votre article sur le FHE). C’est la seule façon de garantir que la confidentialité assurée aujourd’hui ne sera pas déchiffrée dans dix ans. Pour une exploration approfondie de ce risque, consultez notre article sur la Cryptographie Post-Quantique.

À Lire Aussi : Notre Dossier sur l'Architecture IA Zéro Confiance

Le futur de l'Intelligence Artificielle repose sur la décentralisation et la cryptographie de rupture. Explorez les autres piliers de notre dossier dédié à l'IA confidentielle et résiliente :

- Cryptographie Homomorphe (FHE) : Notre guide technique pour calculer et faire de l'inférence sur des données qui restent intégralement chiffrées.

- Post-Quantique (PQC) : Notre analyse sur la nécessité d'adopter des schémas cryptographiques résistant à l'ordinateur quantique pour la sécurité à long terme de l'IA.

Conclusion : L’Ère de l’IA Distribuée

Le Federated Learning n’est pas seulement une technique de confidentialité, c’est un changement de paradigme architectural fondamental pour l’IA. Il oblige les développeurs seniors à repenser le cycle de vie du modèle et à intégrer les contraintes de l’Edge Computing (latence, hétérogénéité des données et des appareils) au cœur du design.

Notre conseil simple : commencez à prototyper avec TensorFlow Federated et intégrez Differential Privacy dès maintenant. Le futur de l’IA confidentielle se construit aujourd’hui.

En maîtrisant la boucle en cinq étapes du FL et les défis inhérents au Non-IID, vous garantissez que l’intelligence de vos modèles peut être exploitée sans jamais compromettre les données brutes de vos clients.

Le FL et le FHE ne sont pas des technologies concurrentes, mais des compléments architecturaux essentiels :

- Le Federated Learning assure que les données ne quittent pas la source, prévenant la fuite massive.

- Le FHE assure que le seul maillon faible qui reste — l’agrégation des gradients sur le serveur central — est également mathématiquement impénétrable.

L’adoption du FL nécessite une expertise en TensorFlow Federated (TFF) et une compréhension approfondie des mécanismes de protection comme la Differential Privacy.

Le moment est venu de déplacer l’intelligence vers les données, et non l’inverse. L’avenir de l’IA confidentielle passe par des architectures distribuées.

Aller plus loin

- TensorFlow Federated : https://www.tensorflow.org/federated

- PySyft (OpenMined) : https://github.com/OpenMined/PySyft